课程介绍

Transformer 在自然语言处理、计算机视觉、语音识别等许多人工智能领域都取得了巨大的成功,也吸引了学术界和行业研究人员的大量兴趣,目前已经成为深度学习领域最强力的工具。Transformer模型最早起源于NLP领域中的机器翻译研究,但是随着近两年的发展,这一模型已经成为了现代NLP技术的基石。当然,Transformer模型不止局限于自然语言处理领域,其在计算机视觉领域也有出色的表现,正如德克萨斯大学奥斯汀分校的计算机科学家 Atlas Wang 说:我们有充分的理由尝试在整个 AI 任务范围内尝试使用 Transformer。因此,无论是学术界的研究人员,还是工业界的相关从业者,都有必要对Transformer技术深入了解,并且紧跟Transformer的前沿研究,以此来夯实自己技术积累。

本次课程,我们将由浅入深的讲解Transformer在NLP和CV领域的模型原理、实现方法以及应用技巧等,全面细致的讲解联邦学习的理论知识体系及其在隐私计算与金融领域的应用。学习过程中,可以通过六大实战项目,拓展思路,融会贯通,从而真正提高自己解决问题能力。

课程亮点

全面技术讲解

涵盖当今应用和科研领域最热门的Transformer与联邦学习,包括70+Transformer模型串讲,三大联邦学习类型+应用案例。

深入技术剖析

深入剖析Transformer与联邦学习模型与框架技术细节及各模块所涵盖最前沿模型原理技术。

六大实战项目

每个模块均设置项目,包含对话系统、文本生成、图像识别、目标检测、隐私计算、金融风控,在应用中提升学生的理论和实践能力。

大牛级导师团队

每个模块均由各自领域内多年一线从业经验科学家或科研学者、工程师讲授,并配有背景优秀经验丰富的助教,致力于带来最优质的学习体验。

课程大纲

第一阶段 · NLP Transformer

· ELMo

· GPT/GPT2/GPT3

· Codex/Alpha-Code

· UniLM/UniLM v2

· NLP模型中的Tokenizer(wordpiece,BPE)

· BERT/RoBERTa/XLM

· SpanBERT

· MASS

· T5

· BART

· Transformer-XL

· Relative Positional Embedding

· Permutation Language Model

· XLNet

· MPNet

· 对比学习中的常见损失函数

· 词粒度的对比:ELECTRA

· 句子粒度的对比:ALBERT,StructBERT

· 其他对比学习结构

· ERNIE/ERNIE2.0/ERNIE3.0

· KnowBERT

· K-BERT

· SentiLR

· KEPLER

· WKLM

· CoLAKE

· 多语言理解:mBERT,Unicoder,XLM-R,MultiFit

· 多语言生成:MASS,mBART,XNLG

· 处理中文的Transformer:BERT-wwm-Chinese,NEZHA,ZEN

· 适用于其他语言的Transformer:BERTje,CamemBERT,FlauBERT,RobBERT

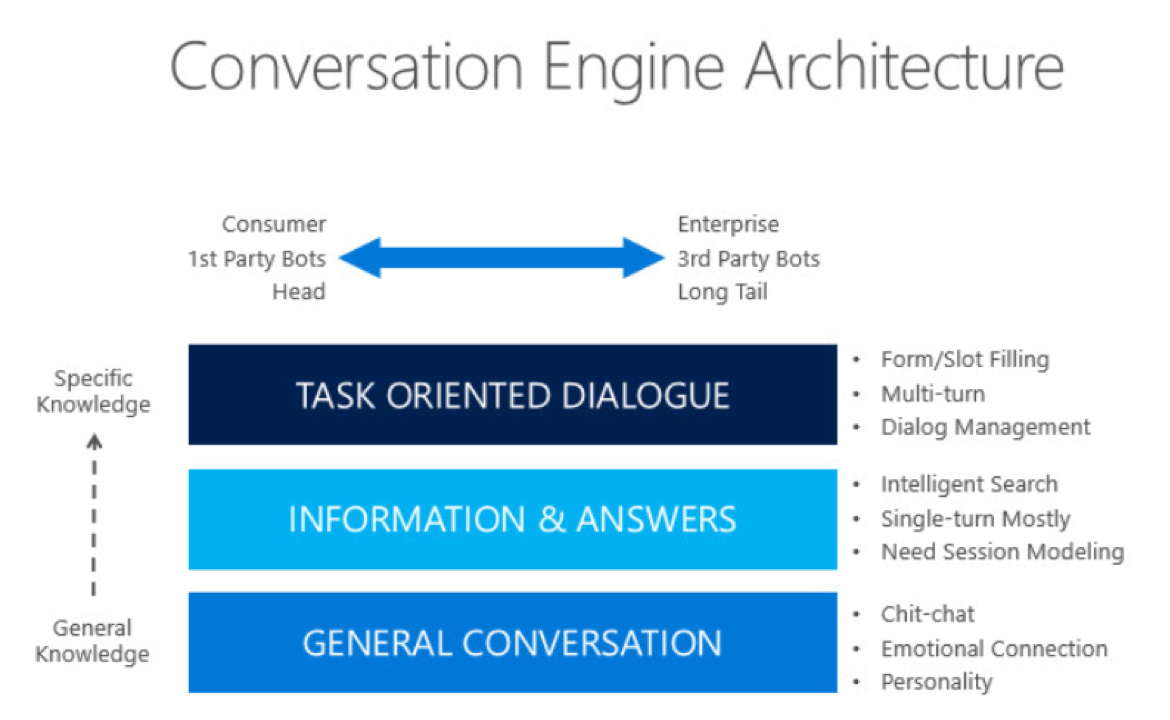

· 对话中的Transformer模型:TransferTransfo,DialoGPT,Blender Bot,Meena,PLATO,LaMDa,GALAXY

· 文本摘要中的Transformer模型:BART,Pegasus

· 更快:Multi-query Attention, Sparse Attention,performer,fastformer

· 更大:Mixture of Expert (MoE)

· 更小:CompressingBERT,Q-BERT,ALBERT,DistillBERT,TinyBERT,MiniLM,BERT-of-Theseus

项目部分

基于Transformer的客服对话系统

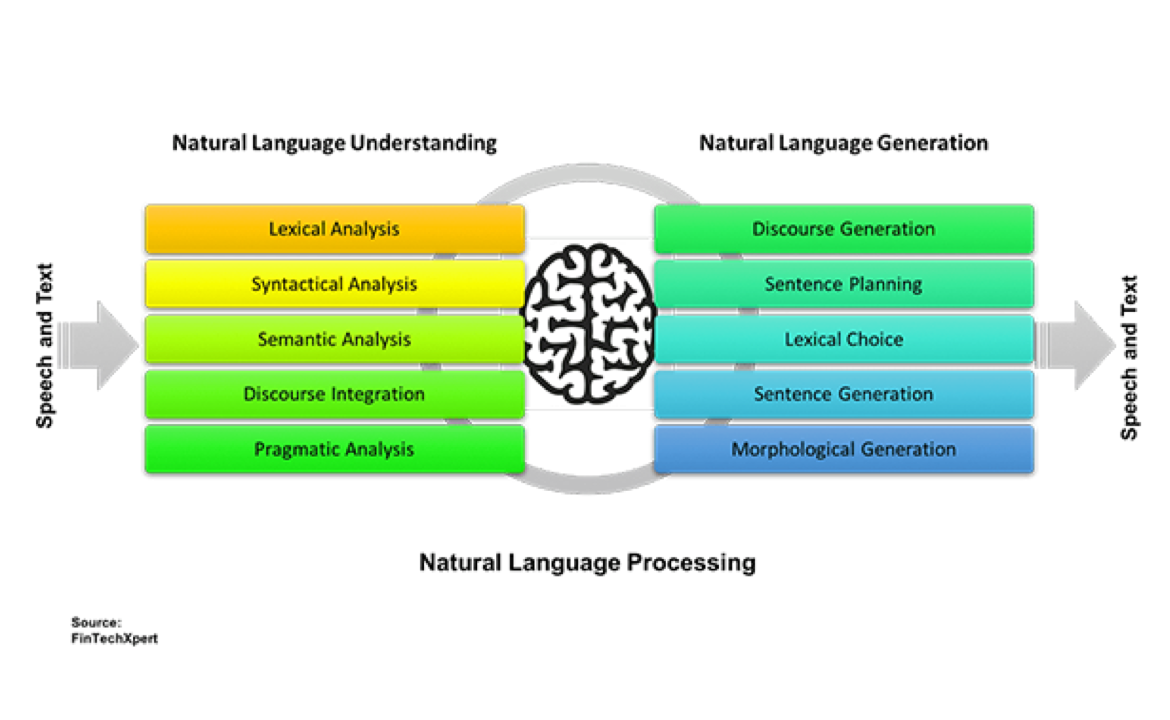

项目内容描述:在本项目中,我们会带领大家实现基于Transformer模型实现自然语言理解(NLU)模块和自然语言生成(NLG)模块。客服对话系统主要实现了自动与用户进行对话的功能,并且帮助用户完成特定的任务,如订机票、酒店、餐馆等。客服对话系统是任务导向对话系统(Task-oriented Dialogue System)中最广泛的一种应用。客服对话系统中最重要的两个模块即为自然语言理解(NLU)模块和自然语言生成(NLG)模块。

项目使用的算法:TextCNN/LSTM;BERT/RoBERTa;CRF;对比学习(Contrastive Loss/Triplet Loss)

项目使用的工具:Python;Pytorch;Elasticsearch;Transformers

项目预期结果:使用基于Transformer的预训练模型实现意图识别模块:a)熟练掌握基于CNN/LSTM的文本分类/序列标注模型;b)熟练掌握基于Transformer的预训练模型的微调方法;c)掌握模型压缩的方法。使用基于Transformer的预训练模型实现检索式对话模型:a)掌握基于Elasticsearch的粗筛模块开发;b)熟练掌握基于Transformer的预训练模型的文本匹配算法

项目对应第几周的课程:1-4周

基于Transformer文本生成模型

项目内容描述:在本项目中,我们会带领大家实现基于Transformer模型的生成式NLG模型。虽然这种类型的NLG模型存在一定的不可控性,但是随着预训练模型技术的发展,我们已经可以得到非常令人振奋的生成效果。甚至在某些特定领域,基于预训练Transformer模型所构建的文本生成已经开始创造巨大的商业价值(如文本摘要,代码生成,心理咨询等)。

项目使用的算法:自回归语言模型(Auto-regressive Language Model)、Multi-input Self-Attention、Top-K/Unclear Sampling、Beam Search、Copy Mechanism

项目使用的工具:Python;Pytorch

项目预期结果:实现基于预训练Transformer的生成式NLG模型。了解文本生成模型的常用技术,包括:a)自回归语言模型中的MLE loss;b)文本生成模型中的各种解码技术;c)使用数据并行的方式利用多张GPU训练模型。有能力独立开发和优化基于预训练模型的文本生成模块。

项目对应第几周的课程:第1,2,5,6,7周

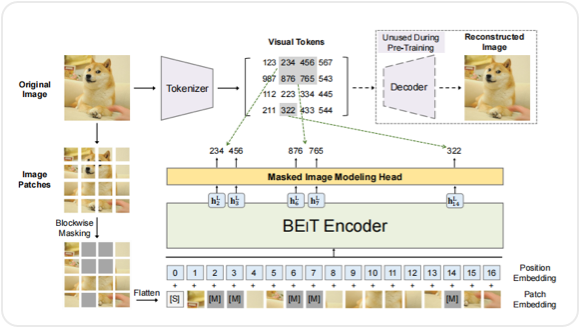

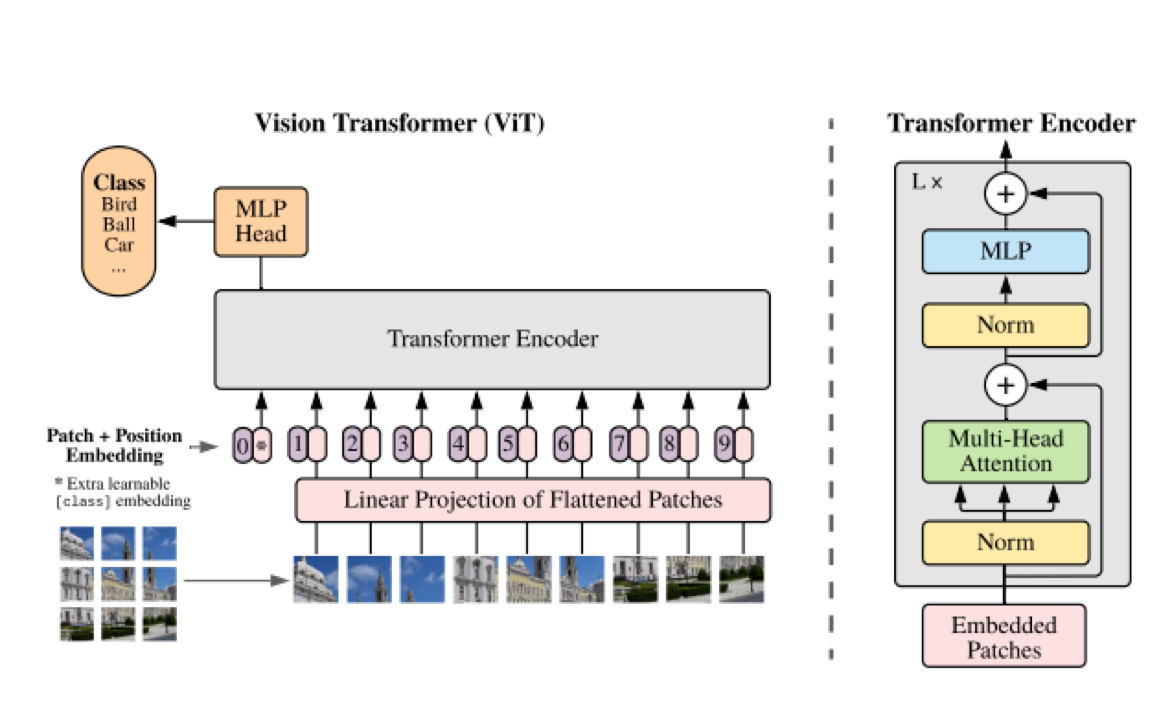

第二阶段 · CV Transformer

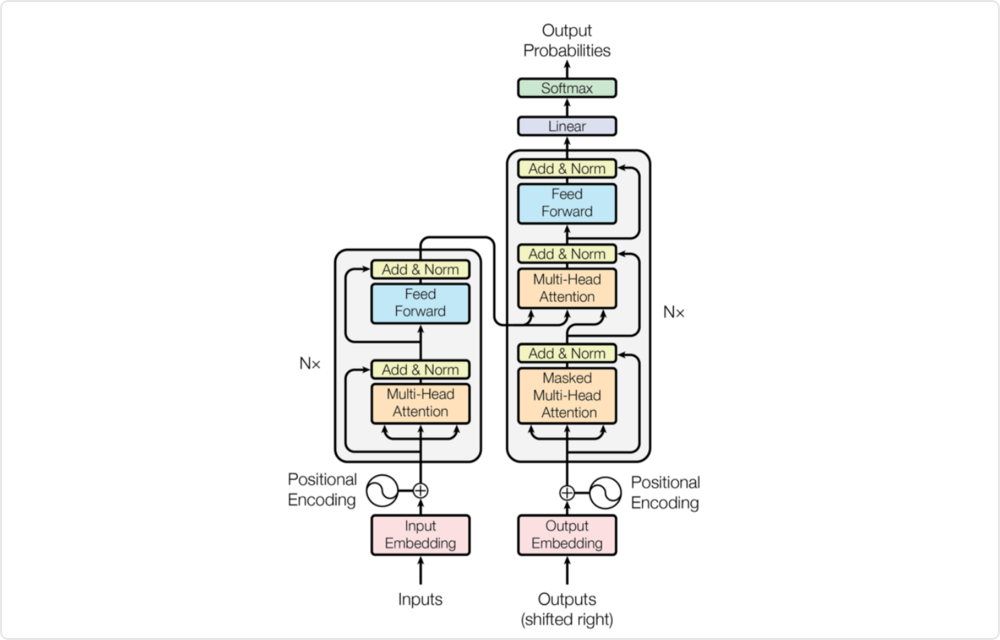

- 本节课将带领大家回顾NLP领域中Transformer/Bert技术。以此深入了解Transformer/Bert技术细节,算法优势。方便学生进一步学习Transformer 技术在其他领域的应用。

- 基于第一节课的内容,进一步研究如何将Transformer思想迁移到两个计算机视觉中分类问题的应用: 图像分类,图像语义分割。以两个经典结构ViT, SegFormer为例,让学生体会如何将Transformer应用到视觉领域的思想。

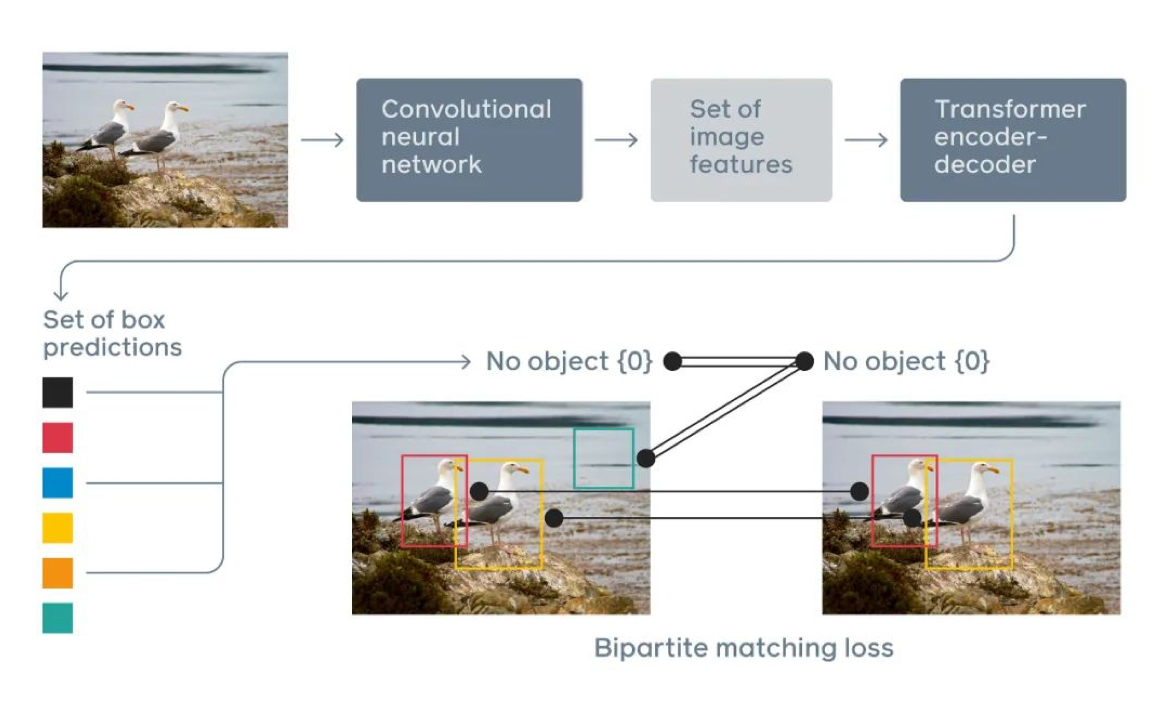

- 本节课将进一步学习如何将Transformer技术应用到目标检测任务重。特别是如何设计Transformer网络结构让神经网络能够同时学习到目标的类别信息与位置信息。

- 本节课将进一步学习如何将Transformer技术应用到视频理解应用中,让Transformer能够同时学习时序上空间上的相关性。以TimeSformer为例,让学生能够深刻体会其中设计思想。

- 高效的Transformer一直是研究者孜孜不倦的追求目标。这次课程将讨论如何设计高效的Transformer 网络结构。本节课将以DeiT, Mobile-Transformer为例,深入学习高效设计网络过程中需要注意的事项。

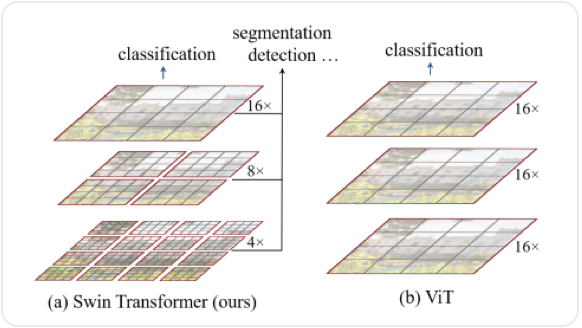

- 本次课程将以SwinTransformer 模型为例,系统性学习SwinTransformer以及其变种模型。目的是让学生能够进一步体会将Transformer应用到视觉任务的网络设计过程中需要注意的问题,有哪些巧妙的思想以及如何通过合理的设计做到并行计算。

- 本节课将跟大家分享3D Point Cloud中的Transformer应用。根据3D Point Cloud数据特点,我们将深入探讨如何设计合适的Transformer网络来处理海量、无结构的点云数据。同时如何进一步修改Transformer结构如何对点云进行分割,聚类等任务。

- 本节课我们将学习multi-modality 中Transformer设计问题。Transformer 在不同的领域得到了很好的应用。最近的工作在探究如何设计合适的Transformer结构处理多模态的数据。我们将以MTTR, MMT, Uniformer等相关Transformer为例子做讲解。

项目部分

基于ViT 模型的图像识别系统

项目内容描述:作为Transformer在视觉领域的一个经典应用案例,ViT模型第一次将NLP领域中Transformer思想应用到图像领域,为后续的一系列Transformer in Vision 设计工作都提供了很好的思路启发。追根溯源,我们将以ViT模型做图像分类任务为例,开启一段如何将Transformer思想应用到视觉领域之旅。

项目使用的算法:ViT model;Cross-entropy loss;Multi-label/multi-class classification;Self-attention;LSTM/GRU

项目使用的工具:Python;Pytorch;OpenCV;ViT

项目预期结果:首先让学生自己动手实现ViT模型,在数据集上测试结果。然后根据官方的实现做对比,如果差异较大需要自己查找原因。掌握如何将Transformer中token, self-attention 思想应用到图像领域。触类旁通,希望学生能够在深刻理解的基础上,能够学生将Transformer思想用到其他相关问题中去。掌握ViT的训练方法,让学生跑完这个pipeline。从数据准备,模型训练,参数调节,到模型测试,指标计算等。

项目对应第几周的课程:1-3周

基于SwinTransformer 模型的图像分类,目标检测任务

项目内容描述:我们在上一个项目中学习了ViT模型,一个成功将Transformer应用到视觉分类问题的视觉Transformer模型。但是ViT模型的设计还是比较单一,存在一些不足。尤其是对图像中存在的问题,例如尺度变换问题没有很好的解决,并且没有考虑到效率问题。在本项目中,我们将学习另一个进阶版的视觉Transformer模型: SwinTransformer模型。

项目使用的算法:SwinTransformer;Cross-Entropy Loss;Regression Loss;Forward-Backward Propagation

项目使用的工具:Python;Pytorch;OpenCV

项目预期结果:学生自己实现SwinTransformer代码(也可参照官方实现),并且参照官方实现优化自己的实现,如果实验效果差异较大,学生需要查找原因。体会用SwinTransformer来做目标检测的思想。掌握如何从代码角度优化实现SwinTransformer的self-attention机制从局部扩展到全局。学生掌握如何将Transformer思想应用到自己工作或者学习中的实际问题中去。

项目对应第几周的课程:6-7周

第三阶段 · 联邦学习与隐私计算

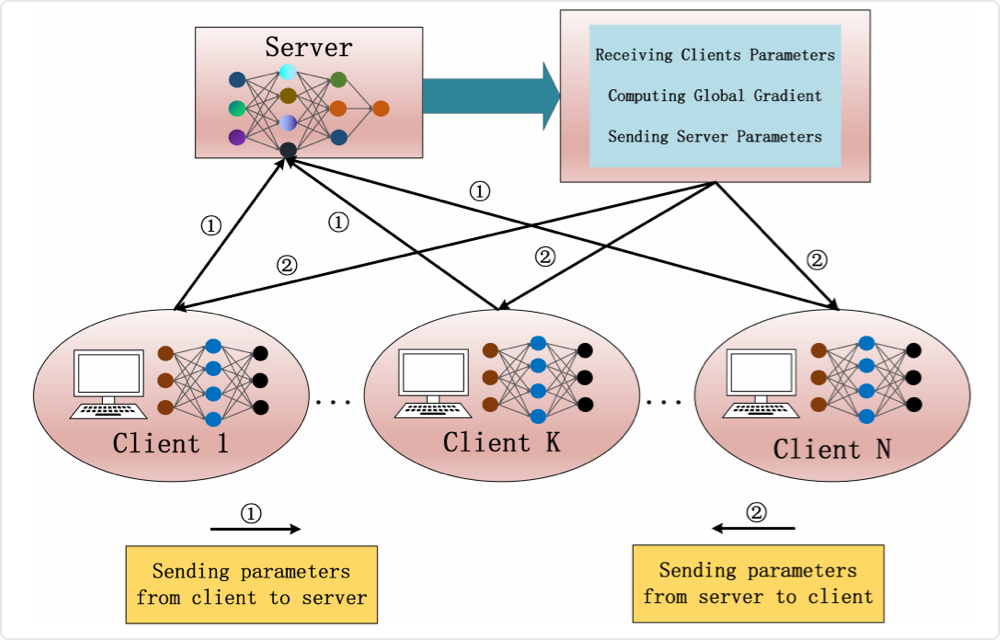

· 联邦学习系统架构

· 联邦学习分类

· 联邦学习常用开源平台

· 联邦学习中的隐私保护技术

· 隐私计算定义与分类

· 同态加密

· 差分隐私

· 安全多方计算

· 分布式机器学习定义

· 分布式机器学习平台

· 大规模机器学习

· 隐私保护机器学习方案

· 分布式机器学习算法

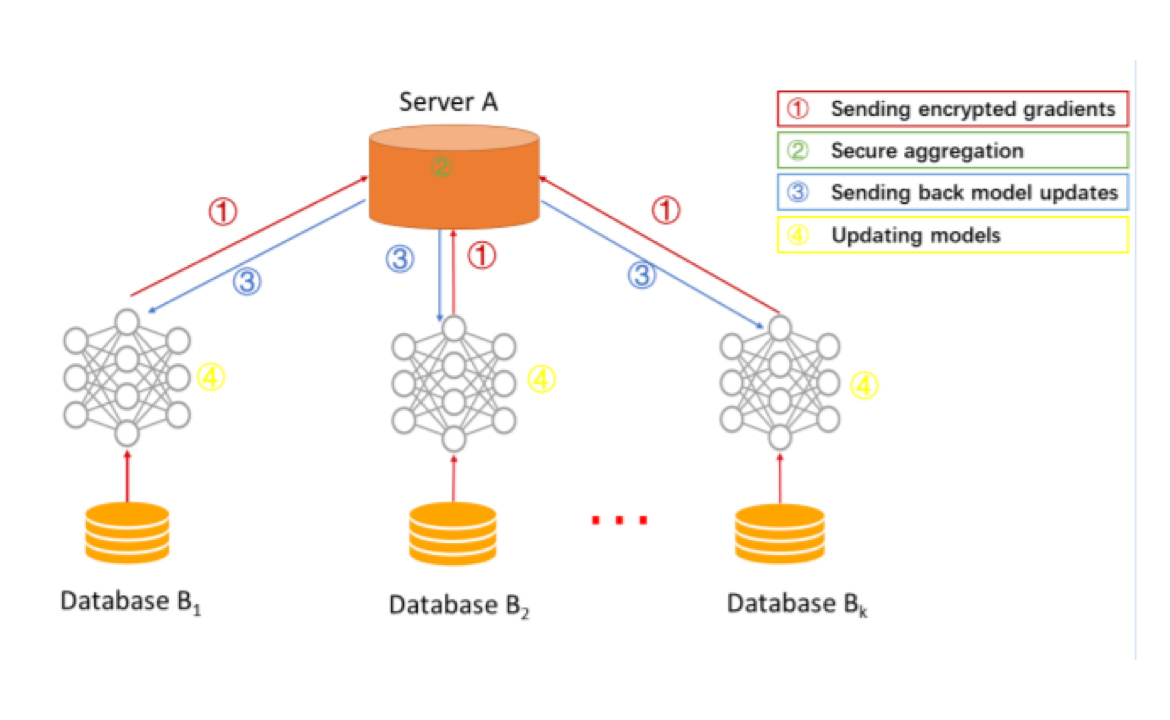

· 横向联邦学习定义

· 横向联邦学习架构

· 联邦平均算法

· 横向联邦学习算法

· 横向联邦学习构建流程

· 横向联邦学习结果分析

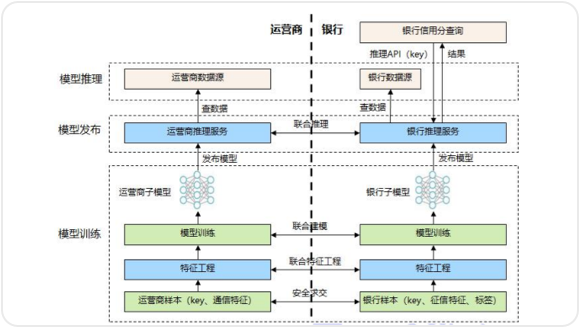

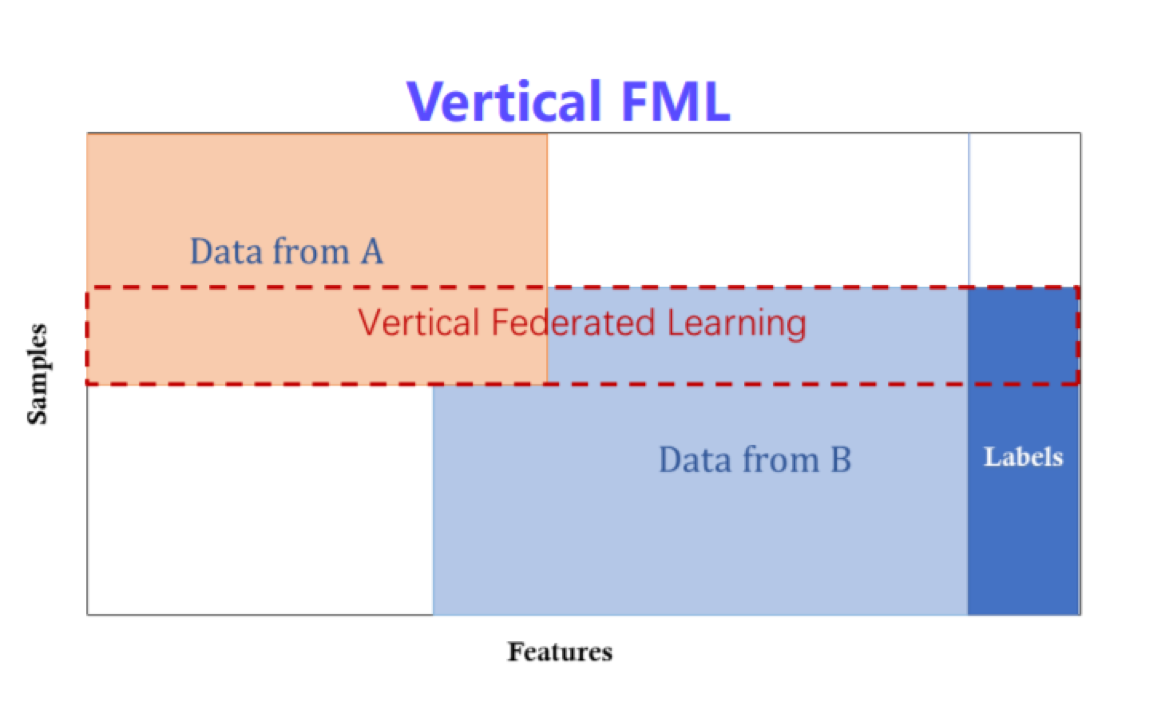

· 纵向联邦学习定义

· 纵向联邦学习架构

· 纵向联邦线性回归

· 纵向联邦决策树

· 联邦迁移学习定义

· 联邦迁移学习框架

· 联邦迁移学习训练与预测

· 联邦迁移学习中的同态加密

· 联邦迁移学习中的秘密共享

· 联邦学习应用案例(计算机视觉领域的联邦学习目标检测网络,政务领域的差分隐私数据共享,智能物联网中的联邦学习用户行为预测,医疗领域的联邦学习健康分析等)

· 联邦学习研究及面临问题

· 隐私计算应用案例

· 隐私计算研究及面临问题

· 金融领域风险监测模型构建流程

· 金融领域风险监测模型结果分析

项目部分

金融隐私计算实战

项目内容描述:讲解联邦学习和隐私计算相关的概念、联邦学习和隐私计算的发展、联邦学习的基础技术(隐私保护技术和分布式学习技术)、横向联邦学习定义、横向联邦学习架构及算法详解,最终使用隐私计算构建金融领域风控模型。

项目使用的算法:横向联邦学习

项目使用的工具:FATE/examples/data,开源数据集

项目预期结果:熟悉联邦学习和隐私计算相关知识和基本概念,熟悉横向联邦学习定义及架构,学会横向联邦学习算法并基于隐私计算实现金融领域风险监测。

项目对应第几周的课程:1-4周

基于联邦学习的金融领域风险监测实战

项目内容描述:讲解纵向联邦学习定义、纵向联邦学习架构及算法详解,讲解联邦迁移学习定义、联邦迁移学习架构及算法详解,讲解联邦学习在业界的应用现状和典型案例,最终使用开源框架FATE实现一个金融领域风险监测模型的构建。

项目使用的算法:联邦学习

项目使用的工具:Python、开源框架FATE

项目预期结果:熟悉纵向联邦学习、联邦迁移学习定义及架构,学会纵向联邦学习、联邦迁移学习算法,并基于开源框架FATE实现一个金融领域风险监测模型。

项目对应第几周的课程:5-8周

授课方式

基础知识讲解

前沿论文解读

该知识内容的实际应用

该知识的项目实战

该知识的答疑解惑

该方向的知识延伸及未来趋势讲解

课程研发及导师团队

你将收获

全面掌握Transformer与联邦学习领域的知识,灵活应用在自己工作中

能够了解Transformer模型与联邦学习框架的实现方式,并熟练掌握其关键技术与方法

深入理解前沿的Transformer与联邦学习技术,拓宽工作和研究的技术视野

短期内对一个领域有全面且系统的认识,大大节省学习时间

认识一群拥有同样兴趣的人、相互交流、相互学习

适合人群

大学生

在职人士

入学标准

· 掌握python

· 具备Pytorch或者TensorFlow 基础知识

· 具备神经网络基本知识

· 具备深度学习模型训练

· 掌握python

· 了解机器学习

· 了解Linux开发环境

· 数学分析/高等数学/概率论/线性代数